什么是VR镜头特效?它与传统特效有何区别?

VR镜头特效是指在360°全景或180°立体视频中,为观众营造沉浸式视觉体验而加入的动态元素。与传统特效最大的不同在于:观众可以自由转动视角,特效必须覆盖所有可见区域,且不能破坏空间一致性。

VR镜头特效怎么做?核心流程拆解

1. 前期规划:如何确定特效范围?

自问:特效会不会挡住观众视线?

答:先用等距柱状投影图(Equirectangular)画出故事板,标记出安全区域与互动热点,避免关键信息被遮挡。

2. 拍摄阶段:怎样同步镜头与特效?

- 使用同步锁相(Genlock)的多机阵列,保证每帧时间码一致

- 拍摄高动态范围(HDR)环境球,为后期光影匹配提供参考

- 记录镜头畸变参数,方便特效反求精确透视

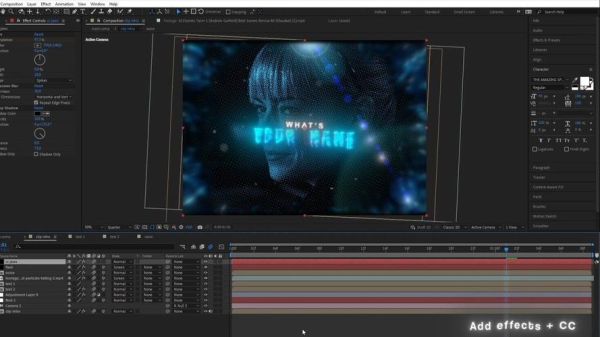

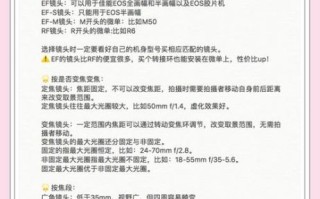

VR特效制作软件推荐:从入门到专业

免费方案:Blender + Mettle Skybox Studio

Blender内置的Eevee实时引擎可直接输出360°视频,配合Skybox Studio插件,能在After Effects里无缝预览VR效果。

付费旗舰:Adobe Substance 3D + Mistika VR

- Substance 3D Painter:绘制PBR材质并实时查看球面反射

- Mistika VR:一键缝合多机位素材,支持深度图合成

独立神器:Carara VR与Notch LC

Carara VR专攻粒子体积光,Notch LC则适合实时交互特效,两者都能输出12K无损序列帧。

技术难点:如何避免VR特效穿帮?

接缝处理

自问:为什么特效在赤道线会撕裂?

答:在Nuke里使用LatLong节点将接缝移至地面盲区,再用Smart Vector跟踪补偿像素偏移。

深度排序

用Z-Depth通道分层渲染,确保火焰、烟雾等体积元素正确遮挡背景物体。

视差匹配

对立体VR项目,需分别调整左右眼的视差偏移量,避免观众产生眩晕。

实战案例:一分钟打造环绕式能量护盾

- 在Blender中创建icosphere,细分后添加wireframe修改器

- 使用shader节点混合自发光与菲涅尔,驱动颜色随摄像机距离变化

- 导出EXR序列,在After Effects中用VR Converter转为立方图

- 添加3D摄像机抖动,让护盾随头部移动产生微动态

性能优化:如何让VR特效不掉帧?

- LOD分级:距离摄像机3米外自动降低粒子数量

- 烘焙光照:将动态光转为静态贴图,减少实时光追开销

- 异步时间扭曲(ATW):补偿帧率波动,防止画面撕裂

未来趋势:AI将如何改变VR特效?

下一代工具如Runway Gen-3已支持文本生成360°特效元素,只需输入“环绕式霓虹能量流”,AI即可输出带深度信息的HDR序列。结合NeRF神经辐射场,未来甚至能实现实时场景重光照,让观众在VR中亲手调整特效颜色与强度。

还木有评论哦,快来抢沙发吧~